Il existe un avenir, semble-t-il, où les pensées ne seront plus de simples images éphémères dans nos esprits, mais pourront devenir des vidéos HQ. Et cela semble être un avenir de plus en plus proche de la réalité. Un groupe de chercheurs talentueux vient d'ouvrir la boîte de Pandore dans le domaine des neurosciences. Pour l'aider, une bonne dose d'IA.

Le cerveau « projecteur »

Jiaxin Qing, Zijiao Chen e Juan Helen Zhou, de l'Université nationale de Singapour et de l'Université chinoise de Hong Kong, a présenté des travaux de recherche plutôt intéressants. L’équipe a combiné les données obtenues à partir de l’imagerie par résonance magnétique fonctionnelle (IRMf) avec l’intelligence artificielle générative à diffusion stable pour créer MinD-Vidéo, un modèle capable de générer des vidéos HQ directement à partir de lectures cérébrales.

Des trucs de science-fiction, me direz-vous : mais non, le tout rigoureusement documenté sur arXiv, e c'est le lien.

Comment fonctionne MinD-Video exactement ?

MinD-Video n'est pas un simple générateur de vidéo, mais tout un système conçu pour faire communiquer le décodage des images effectué par une IA et celui effectué par un cerveau. Mais comment former un tel système ?

Les chercheurs ont utilisé un ensemble de données public, contenant des vidéos et des lectures IRMf associées des sujets qui les regardaient. Et apparemment, le travail a fonctionné admirablement.

Voir les pensées, nous y sommes arrivés

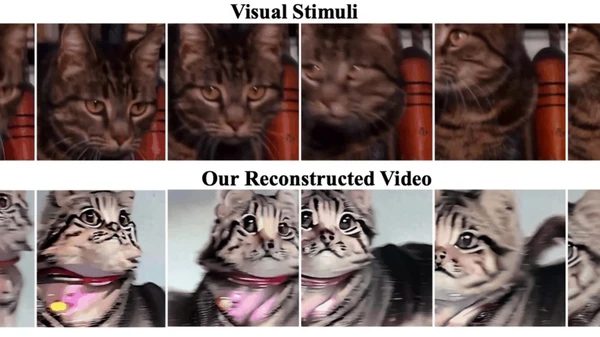

Les vidéos publiées par les scientifiques montrent des résultats vraiment fascinants. Prenons par exemple une vidéo originale mettant en scène des chevaux dans un champ. MinD-Video l'a « reconstruit » en créant une version plus dynamique des chevaux. Dans un autre cas, une voiture traverse une zone boisée et la vidéo reconstituée montre un voyage à la première personne sur une route sinueuse.

Selon les chercheurs, les vidéos reconstituées sont de « haute qualité », avec des mouvements et une dynamique de scène bien définis. Et la précision ? 85%, une nette amélioration par rapport à la tentatives précédentes.

Lecture d'esprit et vidéo HQ, quelle est la prochaine étape ?

« L’avenir est prometteur et les applications potentielles sont immenses. Des neurosciences à interfaces cerveau-ordinateur, nous pensons que notre travail peut avoir un impact important » ont déclaré les auteurs. Et les découvertes ne s'arrêtent pas là : leurs travaux ont mis en évidence le rôle dominant du cortex visuel dans la perception visuelle, et la capacité de leur modèle à apprendre des informations de plus en plus sophistiquées lors de l'entraînement.

Le modèle de diffusion stable utilisé dans cette nouvelle recherche rend la visualisation plus précise. "Un avantage clé de notre modèle par rapport à d'autres modèles génératifs, tels que le GAN, est la capacité de produire des vidéos de meilleure qualité. Il tire parti des représentations apprises de l’encodeur IRMf et utilise son processus de diffusion unique pour générer des vidéos HQ qui s’alignent mieux sur les activités neuronales d’origine », ont expliqué les chercheurs.

Bref, il semble que nous soyons véritablement entrés dans l’ère du télépathie grâce à l'intelligence artificielle. Un champ ouvert aux mille possibilités, où la limite semble n'être que l'imagination.