Dans un environnement lumineux, rempli d'écrans et d'équipements technologiques, un robot est le protagoniste. Sa structure métallique reflète la lumière, mais c'est dans ses « yeux » que se cache la véritable magie. Ces yeux, alimentés par le modèle RT-2 de DeepMind, sont capables de voir, d'interpréter et d'agir.

Alors que le robot se déplace avec grâce, les scientifiques qui l’entourent scrutent chacun de ses mouvements. Il ne s'agit pas simplement d'un morceau de métal et d'un circuit, mais de l'incarnation d'une intelligence qui unit le vaste monde du Web à la réalité tangible.

L'évolution du RT-2

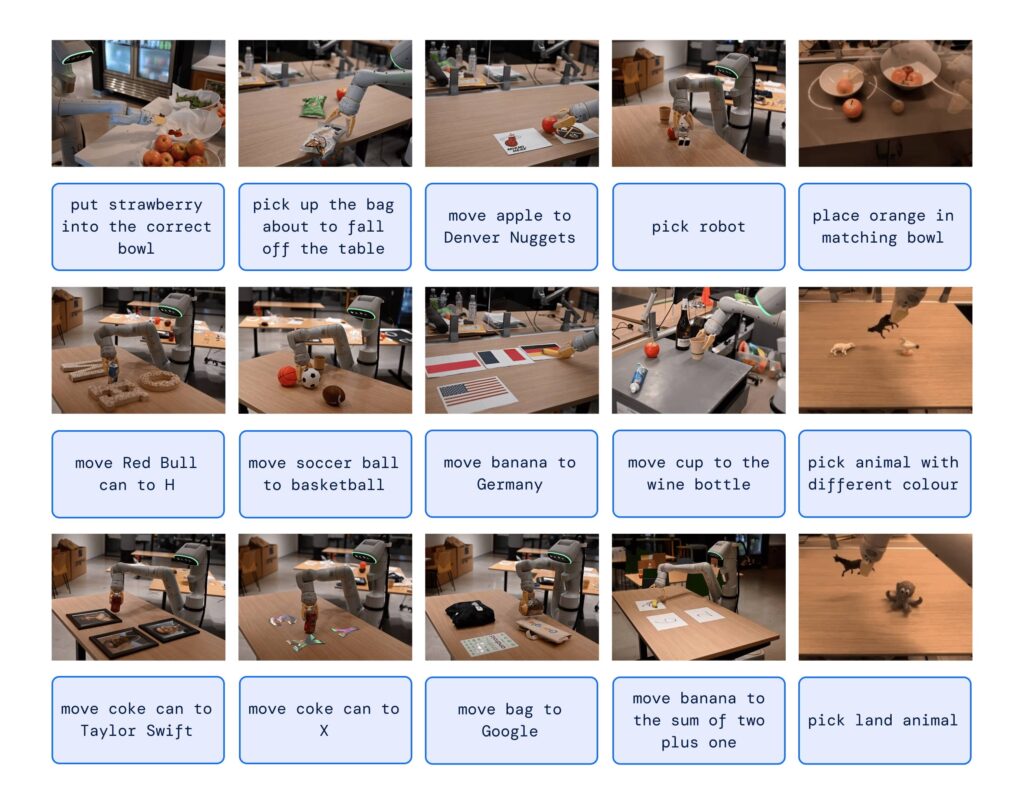

La robotique a parcouru un long chemin ces dernières années, mais DeepMind cela a juste amené le jeu à un tout autre niveau. Illustré dans un papier dès sa sortie il arrive RT-2. Des choses? Il s'agit d'un modèle vision-langage-action (VLA) qui apprend non seulement des données Web, mais également des données robotiques, traduisant ces connaissances en instructions généralisées pour le contrôle robotique.

À une époque où la technologie progresse à pas de géant, le RT-2 représente un pas important, promettant de révolutionner non seulement le domaine de la robotique, mais aussi la façon dont nous vivons et travaillons au quotidien. Mais qu’est-ce que cela signifie en pratique ?

DeepMind RT-2, de la vision à l'action

Les modèles de langage de vision à haute capacité (VLM) ils sont formés sur de grands ensembles de données, ce qui les rend également extraordinairement doués pour reconnaître des modèles visuels ou linguistiques (fonctionnant, par exemple, dans différentes langues). Mais imaginez pouvoir faire faire à des robots ce que ces modèles font. En effet, arrêtez de l'imaginer : DeepMind rend cela possible avec RT-2.

Transformateurs robotiques 1 (RT-1) c'était une merveille en soi, mais RT-2 va plus loin, affichant des capacités de généralisation améliorées et une compréhension sémantique et visuelle qui va au-delà des données robotiques auxquelles il a été exposé.

Raisonnement en chaîne

L'un des aspects les plus fascinants de RT-2 est sa capacité de raisonnement en chaîne. Il peut décider quel objet pourrait être utilisé comme marteau de fortune ou quel type de boisson convient le mieux à une personne fatiguée. Cette capacité de raisonnement profond pourrait révolutionner la façon dont nous interagissons avec les robots.

Et pire encore, vous pourriez encore demander à un robot de vous préparer un bon café pour retrouver un peu de clarté.

Mais comment DeepMind RT-2 contrôle-t-il un robot ?

La réponse réside dans la façon dont il a été formé. En fait, il utilise une représentation qui n'est pas sans rappeler les jetons de langue exploités par des modèles comme ChatGPT.

RT-2 a démontré des capacités émergentes étonnantes, telles que la compréhension des symboles, le raisonnement et la reconnaissance humaine. Des compétences qui montrent actuellement une amélioration de plus de 3x par rapport aux modèles précédents.

Avec RT-2, DeepMind non seulement montré que les modèles vision-langage peuvent être transformés en puissants modèles vision-langage-action, mais il a également ouvert la porte à un avenir dans lequel les robots peuvent raisonner, résoudre des problèmes et interpréter des informations pour effectuer un large éventail de tâches dans le monde réel. monde.

Et maintenant?

Dans un monde où l'intelligence artificielle et la robotique seront de plus en plus centrales, RT-2 nous montre que la prochaine évolution ne sera pas purement technique, mais « perceptuelle ». Les machines comprendront et répondront à nos besoins d’une manière que nous n’aurions jamais imaginée.

Si ce n’est qu’un début, qui sait ce que l’avenir nous réserve.