Des chercheurs de l’Université de Stanford ont réalisé une avancée majeure dans le développement de interfaces cerveau-ordinateur (BCI). En créant une technologie capable de déchiffrer le langage parlé à des vitesses allant jusqu'à 62 mots par minute, l'équipe a amélioré le record précédent de près de 3 fois.

Une évolution qui rapproche un peu plus ces systèmes des rythmes d’une conversation naturelle, et d’une conversion vocale pratiquement instantanée.

Libération conditionnelle

Le co-fondateur de Neuralink avec Elon Musk, Max Hodack, a qualifié la recherche de Stanford de « changement significatif dans l’utilité des implants cerveau-ordinateur ». Mais en quoi cela consiste-t-il exactement ?

L'essentiel de tout le travail, détaillé dans un article auquel je renvoie ici, est la capacité de « traduire » les signaux cérébraux en un discours cohérent à l’aide d’un algorithme d’apprentissage automatique. Et ce, en analysant l’activité cérébrale dans une région relativement petite du cortex.

La cible? Aider les personnes qui ne peuvent plus parler à cause de maladies telles que la SLA à retrouver leur voix. Un véritable saut de qualité : une interface vocale de ce type pourrait accélérer considérablement le décodage des signaux cérébraux.

Les tests

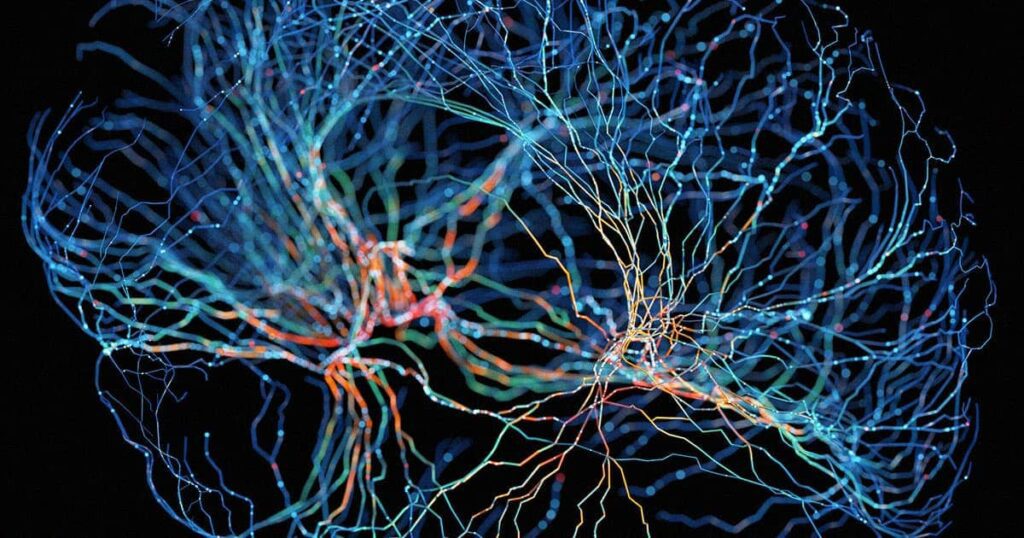

Dans une expérience, l'équipe a enregistré (à partir de deux petites zones du cerveau) l'activité neuronale d'un patient SLA qui peut bouger la bouche mais a des difficultés à former des mots.

À l'aide d'un décodeur de réseau neuronal récurrent capable de prédire le texte, les chercheurs ont ensuite transformé ces signaux en mots. Des mots qui vont à un rythme jamais vu auparavant.

Il a été découvert que l'analyse des mouvements du visage et des activités neuronales associées est suffisamment puissante pour prendre en charge un système d'interface cerveau-ordinateur malgré la paralysie et l'extension limitée du cortex cérébral.

Les défis à relever

Actuellement, le système est rapide, mais encore imparfait : le taux d'erreur du décodeur de réseau neuronal récurrent (RNN) utilisé par les chercheurs c'est encore 20 %.

Les chercheurs le savent bien : « Notre démonstration, écrivent-ils, est la preuve que le décodage des tentatives de décodage des mouvements de parole à partir d’enregistrements intracorticaux est une approche prometteuse, même s’il ne s’agit pas encore d’un système complet et cliniquement viable. »

Pour améliorer le taux d’erreur et optimiser l’algorithme, les études viseront désormais à sonder davantage de zones du cerveau.

Imaginez de telles technologies combinées à l'intelligence artificielle. Des algorithmes capables de cloner parfaitement une voix, comme celui présenté récemment par Microsoft qui ne prend que 3 secondes d'audio.

À l'avenir, personne ne restera silencieux.